Month: January 2018

100 milioni di microlavoratori e… 4 miliardi di operai del click (Il Manifesto, Italia, 27 genn. 2018)

Nell’edizione del 27 gennaio 2018 de Il Manifesto, l’inserto settimanale Alias ospita una dossier assai completo su lavoro, piattaforme e… read more 100 milioni di microlavoratori e… 4 miliardi di operai del click (Il Manifesto, Italia, 27 genn. 2018)

La vie privée et les travailleurs de la donnée (Le Monde, 22 janv. 2018)

Dans Le Monde du 22 janvier 2018, je publie avec Paola Tubaro une tribune à l’occasion des 40 ans de… read more La vie privée et les travailleurs de la donnée (Le Monde, 22 janv. 2018)

![[Séminaire #ecnEHESS] Quels fondements épistémologiques pour le machine learning ? (Jean-Gabriel Ganascia, 12 févr. 2018, 17h)](https://www.casilli.fr/wp-content/uploads/2018/01/IMG_7374.jpg)

[Séminaire #ecnEHESS] Quels fondements épistémologiques pour le machine learning ? (Jean-Gabriel Ganascia, 12 févr. 2018, 17h)

Enseignement ouvert aux auditeurs libres. Pour s’inscrire, merci de renseigner le formulaire. Notre séminaire EHESS Etudier les cultures du numérique… read more [Séminaire #ecnEHESS] Quels fondements épistémologiques pour le machine learning ? (Jean-Gabriel Ganascia, 12 févr. 2018, 17h)

Pourquoi la vente de nos données personnelles (contre un plat de lentilles) est une très mauvaise idée

Jacob dit : ‘Vends-moi aujourd’hui tes données”. “Voici”, s’exclama Esaü, “je m’en vais mourir de faim ! A quoi me… read more Pourquoi la vente de nos données personnelles (contre un plat de lentilles) est une très mauvaise idée

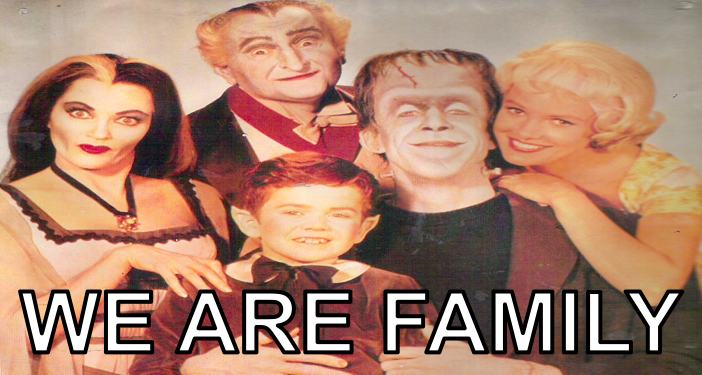

Reforme du News Feed : pourquoi pour Facebook le seul réel qui compte est celui façonné par ta grande-mère

“Je haïssais les foyers, les familles, tous lieux où l’homme pense trouver un repos — et les … read more Reforme du News Feed : pourquoi pour Facebook le seul réel qui compte est celui façonné par ta grande-mère

M, le maudit chatbot (ou, de l’impossibilité de l’automation complète au lendemain de l’échec de l’assistant virtuel de Facebook)

L’année 2018 commence fort chez Zuckerberg. Facebook a décidé de mettre fin à l’expérience de son assistant virtuel, M. Par… read more M, le maudit chatbot (ou, de l’impossibilité de l’automation complète au lendemain de l’échec de l’assistant virtuel de Facebook)

![[Slides séminaire #ecnEHESS] Plateformes numériques : gouvernementalité algorithmique et libertés (Olivier Ertzscheid)](https://www.casilli.fr/wp-content/uploads/2017/12/leviathan.jpg)

[Slides séminaire #ecnEHESS] Plateformes numériques : gouvernementalité algorithmique et libertés (Olivier Ertzscheid)

Dans le cadre du séminaire EHESS Étudier les cultures du numérique j’ai eu le plaisir d’accueillir Olivier Ertzscheid, maître de… read more [Slides séminaire #ecnEHESS] Plateformes numériques : gouvernementalité algorithmique et libertés (Olivier Ertzscheid)

![[Podcast] Entretien sur le travail cognitif (RTS, Suisse, 8 janv. 2017)](https://www.casilli.fr/wp-content/uploads/2016/11/RTSlogo.png)

[Podcast] Entretien sur le travail cognitif (RTS, Suisse, 8 janv. 2017)

Le podcast de l’épisode du 8 janvier 2018 de Versus-Penser, émission de la Radio Télévision Suisse (Espace 2) consacrée aux… read more [Podcast] Entretien sur le travail cognitif (RTS, Suisse, 8 janv. 2017)