Tag: facebook

Facebook contro tutti (intervista in Jacobin Italia, 14 dic. 2018)

Non faccio spesso interviste in italiano, ma quando le faccio passo svariate ore a parlare con il giornaliste Giuliano Santoro. Il risultato è questa intervista-fiume per Jacobin Italia che esplora le relazioni fra Facebook, i mercati, la società e gli stati-nazione.

Why Facebook users’ “strikes” don’t work (and how can we fix them)?

Another day, another call for a Facebook “users’ strike”. This one would allegedly run from May 25 to June 1,… read more Why Facebook users’ “strikes” don’t work (and how can we fix them)?

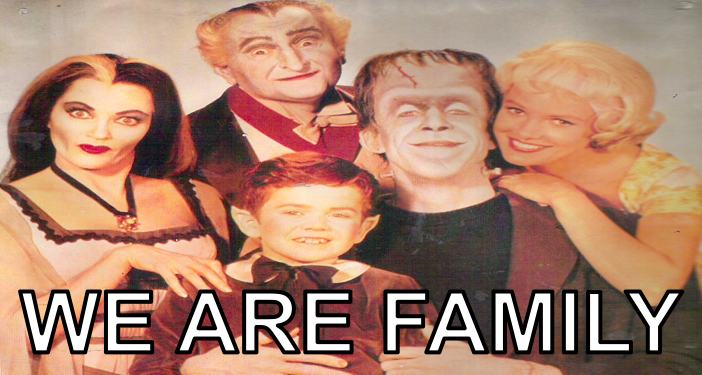

Reforme du News Feed : pourquoi pour Facebook le seul réel qui compte est celui façonné par ta grande-mère

“Je haïssais les foyers, les familles, tous lieux où l’homme pense trouver un repos — et les … read more Reforme du News Feed : pourquoi pour Facebook le seul réel qui compte est celui façonné par ta grande-mère

M, le maudit chatbot (ou, de l’impossibilité de l’automation complète au lendemain de l’échec de l’assistant virtuel de Facebook)

L’année 2018 commence fort chez Zuckerberg. Facebook a décidé de mettre fin à l’expérience de son assistant virtuel, M. Par… read more M, le maudit chatbot (ou, de l’impossibilité de l’automation complète au lendemain de l’échec de l’assistant virtuel de Facebook)

![[Séminaire #ecnEHESS] Nikos Smyrnaios “Les GAFAM : notre oligopole quotidien” (20 mars 2017, 17h)](https://www.casilli.fr/wp-content/uploads/2017/03/dislike.png)

[Séminaire #ecnEHESS] Nikos Smyrnaios “Les GAFAM : notre oligopole quotidien” (20 mars 2017, 17h)

Enseignement ouvert aux auditeurs libres. Pour s’inscrire, merci de renseigner le formulaire. Dans le cadre de notre séminaire EHESS Etudier… read more [Séminaire #ecnEHESS] Nikos Smyrnaios “Les GAFAM : notre oligopole quotidien” (20 mars 2017, 17h)

The business performativity of Mark Zuckerberg’s manifesto

Whenever I hear a businessman talk about building a “healthy society”, my sociologist sense tingles… And although I haven’t been… read more The business performativity of Mark Zuckerberg’s manifesto

[Pocast] Surveillance internationale et médias sociaux avec Edouard Baer (Radio Nova, 2 janv. 2017)

Au petit matin, j’ai eu une conversation intéressante avec Edouard Baer et Thomas Baumgartner sur Radio Nova, dans l’émission Plus… read more [Pocast] Surveillance internationale et médias sociaux avec Edouard Baer (Radio Nova, 2 janv. 2017)

[Vidéo] Grand entretien Mediapart : l’impact des fermes à clic sur les élections (17 déc. 2016)

J’ai rendu visite à la rédaction de Mediapart pour une interview vidéo sur “fake news”, algorithmes et tâcherons du clic…. read more [Vidéo] Grand entretien Mediapart : l’impact des fermes à clic sur les élections (17 déc. 2016)

Bulles de filtres, spirales de silence, algorithmes et politique (NextINpact, 23 nov. 2016)

(Article paru sur NextINpact, 23 novembre 2016) Élection de Trump : influence ou innocence, le rôle de Facebook en questions… read more Bulles de filtres, spirales de silence, algorithmes et politique (NextINpact, 23 nov. 2016)

Qui a fait élire Trump ? Pas les algorithmes, mais des millions de “tâcherons du clic” sous-payés

Ce billet a été publié par L’Obs / Rue89 le 19 novembre 2016. Une version en anglais est disponible ici…. read more Qui a fait élire Trump ? Pas les algorithmes, mais des millions de “tâcherons du clic” sous-payés

![[Pocast] Surveillance internationale et médias sociaux avec Edouard Baer (Radio Nova, 2 janv. 2017)](https://www.casilli.fr/wp-content/uploads/2016/11/novasession.png)

![[Vidéo] Grand entretien Mediapart : l’impact des fermes à clic sur les élections (17 déc. 2016)](https://www.casilli.fr/wp-content/uploads/2016/12/debat-37-illustr01-bis.jpeg)