Tag: gafam

Dans 60 millions de consommateurs (nov. 2019)

Dans le numéro 553 (novembre 2019) du mensuel 60 millions de consommateurs, j’ai accordé un entretien dans le cadre de… read more Dans 60 millions de consommateurs (nov. 2019)

Interview pour l’Institut Français (14 mai 2019)

RencontreDébat d’idées Antonio Casilli Les géants du Net ont le pouvoir de décider ce que nous regardons et apprenons Au… read more Interview pour l’Institut Français (14 mai 2019)

Tribune dans L’Obs “Lettre à l’Europe” (4 mai 2019)

Pour lire la version parue en ligne le 4 mai 2019 sur le site web de L’OBS, cliquer ici. Version… read more Tribune dans L’Obs “Lettre à l’Europe” (4 mai 2019)

An open letter to tell Google to commit to not weaponizing its technology (May 17, 2018)

Following an invitation by Prof. Lilly Irani (UCSD), I was among the first signatories of this ICRAC “Open Letter in… read more An open letter to tell Google to commit to not weaponizing its technology (May 17, 2018)

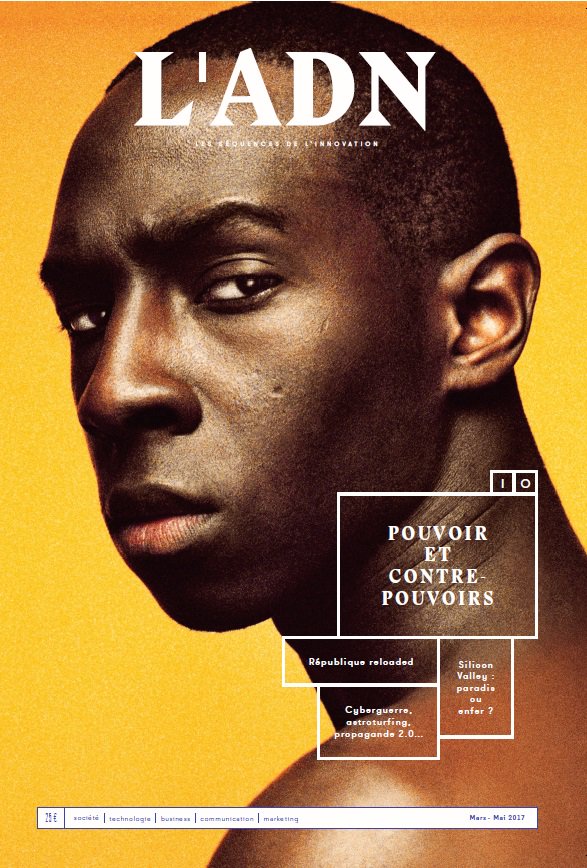

Dans la revue ADN (3 avril 2017)

Dans le numéro 10 de la revue ADN, une longue interview sur données personnelles, pouvoir des GAFAM et surveillance de… read more Dans la revue ADN (3 avril 2017)

![[Séminaire #ecnEHESS] Nikos Smyrnaios “Les GAFAM : notre oligopole quotidien” (20 mars 2017, 17h)](https://www.casilli.fr/wp-content/uploads/2017/03/dislike.png)

[Séminaire #ecnEHESS] Nikos Smyrnaios “Les GAFAM : notre oligopole quotidien” (20 mars 2017, 17h)

Enseignement ouvert aux auditeurs libres. Pour s’inscrire, merci de renseigner le formulaire. Dans le cadre de notre séminaire EHESS Etudier… read more [Séminaire #ecnEHESS] Nikos Smyrnaios “Les GAFAM : notre oligopole quotidien” (20 mars 2017, 17h)

![[Vidéo] Interview “Ouvrez le 1” (France Info Tv, 21 févr. 2021)](https://www.casilli.fr/wp-content/uploads/2021/03/Ouvrez-FrInfoTv.png)