Tag: data

[Podcast] Extracting Data: My Interview in Historic Italian Independent Broadcaster (Radio Onda Rossa, Feb. 19, 2024)

I was interviewed by Radio Onda Rossa, one of the oldest independent Italian “free” radios. The name of the program… read more [Podcast] Extracting Data: My Interview in Historic Italian Independent Broadcaster (Radio Onda Rossa, Feb. 19, 2024)

Le RGPD, un premier pas dans la bonne direction (grand entretien Libération, 25 mai 2018)

Antonio Casilli : «Avec le RGPD, il devient possible de défendre collectivement nos données» Par Christophe Alix — 24 mai… read more Le RGPD, un premier pas dans la bonne direction (grand entretien Libération, 25 mai 2018)

Why Facebook users’ “strikes” don’t work (and how can we fix them)?

Another day, another call for a Facebook “users’ strike”. This one would allegedly run from May 25 to June 1,… read more Why Facebook users’ “strikes” don’t work (and how can we fix them)?

![[Podcast] Vie privée et revente des données personnelles (France Culture, 14 févr. 2017)](https://www.casilli.fr/wp-content/uploads/2015/11/France_Culture_logo_2005.svg_.png)

[Podcast] Vie privée et revente des données personnelles (France Culture, 14 févr. 2017)

Podcast de mon intervention à La Grande Table de France Culture. Vie privée, plateformes numériques et les idiots utiles qui… read more [Podcast] Vie privée et revente des données personnelles (France Culture, 14 févr. 2017)

Pourquoi la vente de nos données personnelles (contre un plat de lentilles) est une très mauvaise idée

Jacob dit : ‘Vends-moi aujourd’hui tes données”. “Voici”, s’exclama Esaü, “je m’en vais mourir de faim ! A quoi me… read more Pourquoi la vente de nos données personnelles (contre un plat de lentilles) est une très mauvaise idée

Economie et politique des plateformes numériques : le programme de mon séminaire #ecnEHESS 2016-17

FINALLY ! Pour la neuvième année consécutive, mon séminaire Étudier les cultures du numérique : approches théoriques et empiriques (#ecnEHESS)… read more Economie et politique des plateformes numériques : le programme de mon séminaire #ecnEHESS 2016-17

![[Slides séminaire #ecnEHESS] Mechanical Turk et le travail invisible des données (7 mars 2016)](https://www.casilli.fr/wp-content/uploads/2016/02/Crowdsourcing.jpg)

[Slides séminaire #ecnEHESS] Mechanical Turk et le travail invisible des données (7 mars 2016)

Pour la séance du 7 mars 2016 de mon séminaire EHESS Etudier le cultures du numérique, j’ai eu le plaisir… read more [Slides séminaire #ecnEHESS] Mechanical Turk et le travail invisible des données (7 mars 2016)

Dans le Cahier IP – CNIL (17 nov. 2015)

Dans le Cahier Innovation CNIL “Les Données, Muses & Frontières de la Création” j’ai le plaisir d’être interviewé avec le collègue… read more Dans le Cahier IP – CNIL (17 nov. 2015)

[Radio] ¿Qué es el Digital Labor? (RFI, 16 oct. 2015)

Radio RFI International interviewed me about the latest book I co-authored Qu’est-ce que le digital labor ? (INA, 2015) –… read more [Radio] ¿Qué es el Digital Labor? (RFI, 16 oct. 2015)

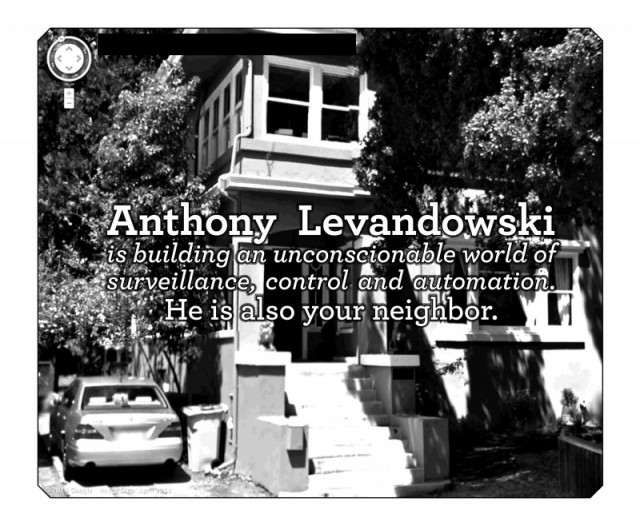

Privacy is not dying, it is being killed. And those who are killing it have names and addresses

Quite often, while discussing the role of web giants in enforcing mass digital surveillance (and while insisting that there is… read more Privacy is not dying, it is being killed. And those who are killing it have names and addresses

![[Podcast] Extracting Data: My Interview in Historic Italian Independent Broadcaster (Radio Onda Rossa, Feb. 19, 2024)](https://www.casilli.fr/wp-content/uploads/2024/03/ror-480x238.jpg)

![[Radio] ¿Qué es el Digital Labor? (RFI, 16 oct. 2015)](https://www.casilli.fr/wp-content/uploads/2015/10/logo-rfi-haute-def.jpg)