Tag: censure

[Vidéo] Interview sur censure et médias sociaux (RTS, 27 janv. 2021)

Réseaux sociaux: la censure ou la bavure? J’étais l’invité de l’émission Forum sur la Radio Télévision Suisse.

![[Séminaire #ecnEHESS] “Communiquer avec modération” avec Sarah T. Roberts (Gaité Lyrique, 9 janv. 2020, 19h)](https://www.casilli.fr/wp-content/uploads/2019/12/20190409-150121-1.jpg)

[Séminaire #ecnEHESS] “Communiquer avec modération” avec Sarah T. Roberts (Gaité Lyrique, 9 janv. 2020, 19h)

Le prochain rendez-vous de notre séminaire Étudier les cultures du numérique inaugure une collaboration avec la Gaîté Lyrique. De janvier… read more [Séminaire #ecnEHESS] “Communiquer avec modération” avec Sarah T. Roberts (Gaité Lyrique, 9 janv. 2020, 19h)

Interview pour l’Institut Français (14 mai 2019)

RencontreDébat d’idées Antonio Casilli Les géants du Net ont le pouvoir de décider ce que nous regardons et apprenons Au… read more Interview pour l’Institut Français (14 mai 2019)

Une tribune dans Libération (3 janv. 2016)

Avec Paola Tubaro, je co-signe une tribune dans Libération, à partir de notre ouvrage Le phénomène “pro-ana”, paru aux Presses… read more Une tribune dans Libération (3 janv. 2016)

[Slides séminaire #ecnEHESS] Christophe Benavent : Plateformes et gouvernementalité algorithmique (21 nov. 2016, 17h)

Pour la première séance de mon séminaire EHESS Étudier les cultures du numérique : approches théoriques et empiriques nous avons… read more [Slides séminaire #ecnEHESS] Christophe Benavent : Plateformes et gouvernementalité algorithmique (21 nov. 2016, 17h)

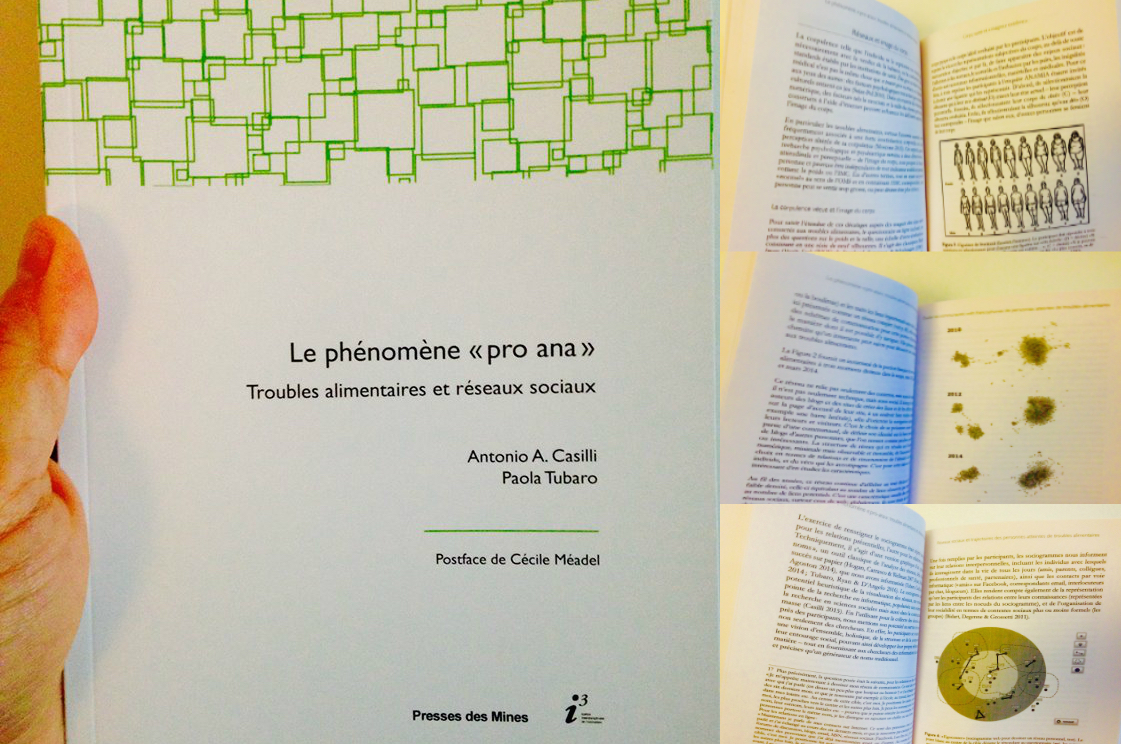

Dernier ouvrage : “Le phénomène “pro-ana’. Troubles alimentaires et réseaux sociaux” (Oct. 2016)

Mon dernier ouvrage (co-écrit avec Paola Tubaro) est Le phénomène “pro-ana”. Troubles alimentaires et réseaux sociaux, paru aux Presses des… read more Dernier ouvrage : “Le phénomène “pro-ana’. Troubles alimentaires et réseaux sociaux” (Oct. 2016)

Google censure les gros mots : une non-nouvelle [Updated 02.12.13]

Depuis quelques jours cette nouvelle fait le tour des Internets. Le contenu des Google Hangouts sous surveillance automatisée ? Mystère… read more Google censure les gros mots : une non-nouvelle [Updated 02.12.13]

[Podcast] La vie et l'oeuvre d'Aaron Swartz (France Culture, Place de la Toile, 19 janv. 2013)

Podcast de l’émission Place de la Toile, le magazine des cultures numériques de France Culture. Le journaliste Xavier de la Porte et le sociologue Antonio Casilli, auteur de Les liaisons numériques. Vers une nouvelle sociabilité ? (Ed. du Seuil) analysent la vie, l’héritage et les tragiques événements ayant porté au suicide de l’activiste des libertés numériques Aaron Swartz…

Tribune d'Antonio Casilli sur la mort d'Aaron Swartz (Huffingtonpost, 13 janv. 2013)

Le Huffingtonpost France donne la parole à Antonio A. Casilli, sociologue et auteur de Les liaisons numériques. Vers une nouvelle sociabilité… read more Tribune d'Antonio Casilli sur la mort d'Aaron Swartz (Huffingtonpost, 13 janv. 2013)

![[Vidéo] Dans l’émission “Alors on pense” (France Info Tv, 12 févr. 2021)](https://www.casilli.fr/wp-content/uploads/2019/01/france-info-logo.jpg)

![[Vidéo] Interview sur censure et médias sociaux (RTS, 27 janv. 2021)](https://www.casilli.fr/wp-content/uploads/2016/11/RTSlogo.png)

![[Slides séminaire #ecnEHESS] Christophe Benavent : Plateformes et gouvernementalité algorithmique (21 nov. 2016, 17h)](https://www.casilli.fr/wp-content/uploads/2016/11/gears-and-86739623.jpg)

![Google censure les gros mots : une non-nouvelle [Updated 02.12.13]](https://www.casilli.fr/wp-content/uploads/2013/11/swearing.jpg)